Once a colleague of mine told me he had sent out about one thousand resumes to find a suitable job. I was impressed and could…

Leave a CommentTag: R

The temporary directory and files Firstly let’s create a folder to work within a temporary directory. Look for details on how to work with temporary…

Leave a CommentWhen temporary files in R become handy Every time you need to download a file from anywhere to extract data from it and then throw…

Leave a CommentThe problem and the opportunity Flows of data in organizations today are constant and unstoppable. A report based on a data slice from a specific…

Leave a CommentПродолжаю тему с однофакторым регрессионным анализом в R. Теперь мне интересно применить инструменты визуализации, доступные в R-библиотеке ggvis, для диагностики регрессионной модели. Здесь же мы…

3 CommentsНа основе книги An Introduction to Statistical Learning with Applications in R авторов Gareth James, Daniela Witten, Trevor Hastie и Robert Tibshirani. Бесплатная копия книги…

1 CommentВы открыли продолжение статьи об основах ggplot2. Читайте начало в Что такое грамматика графики ggplot2 (ч.1) ggplot2: сопоставления, визуальные средства, статистические преобразования и слои Подписи…

1 CommentПродолжение. Читайте начало в Что такое грамматика графики ggplot2 (ч.1) Читайте продолжение в Названия элементов графика ggplot2: название графика, осей, легенд Визуальные средства и геометрические…

3 CommentsОднажды я организовывал в Пскове опрос пешеходов, целью которого было выявить, какой из ряда планируемых тарифов сотового оператора больше нравится респондентам. После пары дней работы…

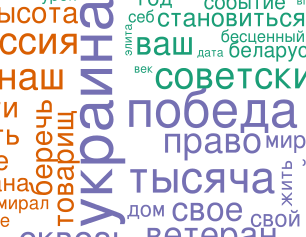

Leave a CommentСравним речи, которые произнесли руководители России, Белоруссии и Украины 9 мая 2014 года. Сделаем это с помощью визуализации текстов в виде облака слов. Как интерпретировать…

Leave a Comment