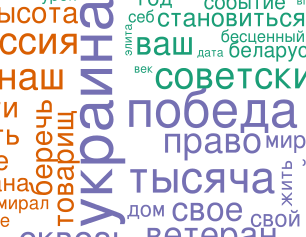

Сравним речи, которые произнесли руководители России, Белоруссии и Украины 9 мая 2014 года. Сделаем это с помощью визуализации текстов в виде облака слов. Как интерпретировать…

Leave a CommentTag: wordcloud

Обработка естественно-языковых текстов (Natural language processing) – это одна из областей, в которых применяется R. В этой публикации вы познакомитесь с базовыми инструментами анализа, основанного…

65 Comments